Padroneggia il Dialogo con l'IA:

dalla Teoria alla Produzione

La qualità dei tuoi risultati dipende dalla qualità dei tuoi prompt.

Scopri le strategie e i framework per progettarli in modo scientifico e creativo.

La Mia Filosofia

Il mio approccio non ammette scorciatoie. Ogni progetto si fonda su tre principi fondamentali:

1. Analisi Rigorosa

Nessun problema può essere risolto senza prima averlo compreso alla radice. Parto sempre dai principi fondamentali per costruire una diagnosi precisa, senza lasciare nulla al caso.

2. Soluzioni Definitive

Il mio obiettivo non è applicare una soluzione temporanea, ma sradicare il problema per sempre. Progetto sistemi robusti, scalabili e manutenibili che portano risultati misurabili e duraturi.

3. Conoscenza Condivisa

Un lavoro è finito solo quando il mio cliente o il suo team è completamente autonomo. Fornisco sempre spiegazioni chiare e documentazione completa, perché la vera crescita nasce dalla consapevolezza e dalla condivisione.

Le Soluzioni

Che tu sia un appassionato curioso, un professionista in cerca di maestria o un'azienda pronta alla trasformazione, qui trovi il percorso giusto per te.

PER GLI APPASSIONATI

Viaggio al Cuore dell'IA

L'IA ti affascina e vuoi capirne i segreti?

Accedi a guide chiare, analisi approfondite e contenuti esclusivi per navigare la rivoluzione tecnologica con consapevolezza e passione.

PER I PROFESSIONISTI

Maestria Individuale

Accedi a risorse, framework e corsi avanzati progettati per trasformarti da semplice utilizzatore a un vero esperto di IA. Aumenta il tuo valore sul mercato e la qualità del tuo lavoro

PER LE AZIENDE

Trasformazione Strategica

Dalla formazione su misura per i tuoi team all'audit dei processi esistenti. Integro l'IA nella tua organizzazione per creare un vantaggio competitivo reale, misurabile e sostenibile.

Cosa Dicono di Me

"Alberto è un insegnante estremamente competente e flessibile. È preciso, affidabile e cerca sempre di fare il suo meglio per mettere al primo posto l'esigenza dello studente. Consigliatissimo!"— Alessandro

"Alberto è un insegnante puntuale, preciso, molto disponibile e piacevole. L'impressione è che la sua conoscenza e competenza si estendono molto oltre l'argomento specifico, e ciò rende estremamente interessante l'interazione."— Claudio

"Consiglio Alberto come insegnante in quanto è stato capace di spiegarmi argomenti molto complessi partendo da zero, senza dare per scontato nulla, riuscendo ad usare parole semplici ed esempi pratici."— Lucia

Raccontami la tua sfida.

Diventa un Insider

Iscriviti per ricevere analisi approfondite, strategie di Prompt Engineering e aggiornamenti esclusivi su corsi e masterclass

© 2025 Alberto Furnari - albertofurnari.com

All rights reserved.

Grazie!

La tua Mappa per le terre inesplorate del Prompting è in viaggio.

Considerami la tua guida. Controlla la tua strumentazione (l'email) per sbloccare il tuo primo obiettivo.

La Mia Storia

Trasformo la Complessità in Soluzioni d'Eccellenza.

Sistemi AI che funzionano. Conoscenza che ispira. Risultati che restano.

Il mio lavoro si fonda su una convinzione: la tecnologia, anche la più avanzata, deve essere uno strumento per creare valore chiaro e tangibile. Che si tratti di progettare un'infrastruttura AI per un'azienda o di scrivere un libro, il mio obiettivo non cambia: fornire soluzioni definitive e conoscenza profonda, senza compromessi.

Per le Aziende: Dalla Sfida alla Soluzione

Come Senior System Engineer e Technical Lead, non mi limito a implementare tecnologia. Collaboro con te per risolvere le tue sfide più complesse.

Ingegneria AI su Misura: Progetto e sviluppo sistemi di Intelligenza Artificiale robusti, scalabili e integrati nel tuo business. Il mio focus è sull'automazione del ciclo di vita (LifeCycle Automation) per garantirti efficienza e un vantaggio competitivo duraturo.

Architetture Software d'Avanguardia: Costruisco soluzioni basate su algoritmi avanzati e codice impeccabile, pensate non solo per funzionare oggi, ma per evolvere con te domani.

Hai un progetto ambizioso o un problema che sembra intrattabile?

Per Chi Vuole Imparare: Dalla Teoria alla Padronanza

Credo che la conoscenza di qualità debba essere accessibile. Per questo traduco la mia esperienza sul campo in risorse formative chiare e potenti.

Il Mio Libro: "Ricalibrare le parole"

Non è solo un manuale sul Prompt Engineering. È la guida strategica per dialogare con l'intelligenza artificiale, trasformandola da semplice strumento a partner creativo. Un'immersione pratica per dominare la tecnologia che sta definendo il nostro futuro.

Formazione e Prossime Pubblicazioni

Come formatore, porto l'esperienza del mondo reale direttamente in aula (virtuale o fisica). Attualmente, sto distillando anni di studio e pratica in una serie di testi definitivi su Matematica, Informatica e AI, pensati per chi non si accontenta di sapere il "cosa", ma vuole padroneggiare il "perché".

Vuoi accedere a contenuti esclusivi e rimanere aggiornato sulle mie prossime uscite?

La Mia Filosofia: Rigore, Pragmatismo e Visione

Ogni soluzione che propongo, che sia codice o un capitolo di un libro, si fonda su tre pilastri che guidano il mio lavoro:

Rigore e Profondità: Credo nell'analisi approfondita come base per ogni progetto. Solo comprendendo le radici di un problema si possono costruire soluzioni solide e affidabili, pensate per durare nel tempo.

Pragmatismo Orientato al Risultato: La teoria è il punto di partenza, l'impatto concreto è la destinazione. Il successo di una soluzione si misura dai risultati tangibili che genera: efficienza, valore e un miglioramento misurabile.

Innovazione come Sguardo al Futuro: Esploro le frontiere della tecnologia non per seguire le mode, ma per anticipare le opportunità. Il mio obiettivo è offrirti soluzioni che non solo risolvano il problema di oggi, ma che ti diano gli strumenti per cogliere le sfide di domani.

Questo è l'impegno che porto in ogni progetto.

La firma che appongo su ogni riga di codice e su ogni pagina che scrivo.

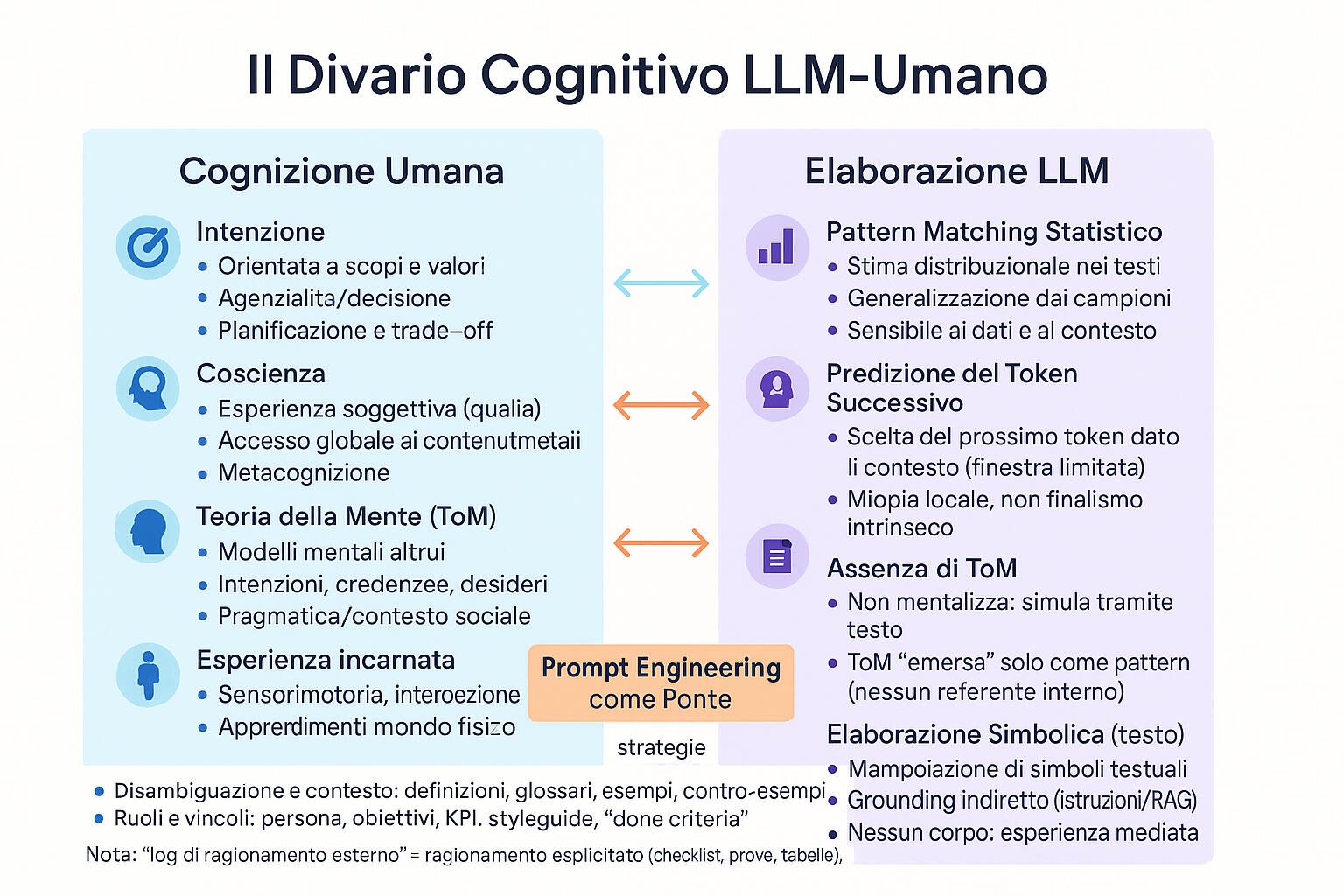

Differenze tra LLM e Coscienza Umana

Oltre lo specchio statistico, la natura dei Large Language Models (LLM) come interlocutori si discosta radicalmente dalla cognizione e comunicazione umana. Questa non è una questione di "conversazione" nel senso umano del termine, bensì un rigoroso esercizio di ingegneria della comunicazione, noto come prompt engineering. Per padroneggiare questa disciplina emergente, è indispensabile una comprensione rigorosa non solo di ciò che gli LLM sono e sanno fare, ma, crucialmente, di ciò che, ontologicamente, non sono e non possono essere. La nostra tendenza innata all'antropomorfizzazione – l'attribuire intenzioni, pensieri ed esperienze umane a entità non umane – sebbene naturale, nell'interazione con gli LLM cessa di essere un'innocua stranezza filosofica per divenire il principale ostacolo operativo. Essa ci induce a proiettare sul modello capacità cognitive che esso, per sua natura puramente computazionale e statistica, non possiede, aspettandoci che "legga tra le righe" o "capisca al volo", quando in realtà stiamo interagendo con un sofisticatissimo motore di pattern matching. Questa analisi approfondisce le tre differenze ontologiche fondamentali che separano la cognizione umana dall'elaborazione statistica degli LLM, per poi esplorare le loro dirette implicazioni pratiche. Comprendere questo divario non è un mero esercizio accademico, ma il prerequisito indispensabile non solo per formulare prompt efficaci, ma per trasformare l'interazione con l'AI da un dialogo frustrante a uno strumento strategico di potenziamento della nostra stessa consapevolezza metalinguistica.La prima e più fondamentale distinzione risiede nell'Assenza di Intenzione (Mancanza di Obiettivi Cognitivi Interni) intrinseca all'LLM. Ogni atto comunicativo umano è sotteso da un'intenzione, guidato da uno scopo cognitivo interno: informare, persuadere, chiedere, connettersi emotivamente o esplorare un'idea. Il nostro linguaggio è lo strumento diretto dalla nostra volontà e dai nostri obiettivi, supportato da un "modello mentale" di ciò che vogliamo ottenere. Un LLM, al contrario, non possiede obiettivi cognitivi interni o una "volontà". Il suo funzionamento si basa sul principio fondamentale della predizione del token successivo, un processo puramente statistico e reattivo. Non agisce; reagisce al prompt. Non "vuole" informare; si limita a generare la sequenza di token che, in base ai miliardi di pattern appresi dai dati di training, risulta statisticamente più probabile dato il contesto fornito. L'illusione di intenzione (ad esempio, una risposta che "sembra" premurosa o "utile") è un fenomeno emergente, un artefatto della sua capacità di replicare alla perfezione i pattern linguistici di testi creati da esseri umani che, quelli sì, avevano un'intenzione. Si potrebbe pensare all'LLM come a un'orchestra incredibilmente talentuosa ma senza direttore: esegue una sinfonia di parole con virtuosismo tecnico impeccabile, avendo interiorizzato miliardi di spartiti (dati di training) che rappresentano la musica del linguaggio umano, ma senza una propria intenzione artistica o una coscienza che "senta" la musica che produce. L'implicazione pratica è radicale: l'intenzione comunicativa risiede esclusivamente nell'utente. L'operatore umano diventa il "direttore d'orchestra" cognitivo, l'unica fonte di scopo nell'interazione. Il prompt engineering diventa così l'atto cruciale di tradurre un complesso stato interno umano (l'intento) in un input testuale (una sequenza di token) così preciso, strutturato e privo di ambiguità da orientare con successo la cascata probabilistica del modello verso l'output desiderato. Non possiamo presupporre che l'AI "capisca" il nostro scopo; dobbiamo definirlo con precisione chirurgica, fornendo ruolo, contesto e formato.La seconda differenza cruciale è l'Assenza di Coscienza (Mancanza di Esperienza Soggettiva) nell'LLM. La cognizione umana è radicata in un "sé" esperienziale: non siamo solo processori di informazioni, ma esseri che provano qualcosa nell'esserlo. Abbiamo credenze, formuliamo opinioni, proviamo emozioni e possediamo un'esperienza soggettiva, in prima persona, del mondo e di noi stessi. La nostra comprensione è filtrata da questa consapevolezza. Al contrario, dietro la generazione testuale del modello non esiste un "sé" che pensa, sente o crede; è un meccanismo vuoto di esperienza. Quando un LLM genera una frase che esprime un'opinione ("Penso che Picasso sia stato rivoluzionario"), un'emozione ("Mi dispiace per la tua perdita") o un'affermazione di conoscenza ("So che la capitale della Francia è Parigi"), non sta esprimendo una "credenza", un "sentimento" o uno "stato di conoscenza". Sta, ancora una volta, generando la sequenza di token statisticamente associata, nei suoi dati, a quel tipo di espressione. Un LLM che genera un testo eloquente sull'empatia non "prova" empatia; replica in modo impeccabile i pattern linguistici umani usati per descriverla, avendoli osservati milioni di volte. L'implicazione pratica è che qualsiasi affidamento su una presunta "comprensione" soggettiva, empatica, etica o morale del modello è tecnicamente infondato e operativamente pericoloso. Il modello non può "leggere tra le righe" per cogliere il nostro stato emotivo, né può applicare un giudizio etico genuino a una situazione complessa. Può solo replicare le discussioni etiche o emotive presenti nei suoi dati. Pensare che un LLM abbia un'opinione o un giudizio etico è come chiedere a un dizionario di avere un'opinione morale sulla parola "giustizia": può descriverne gli usi, ma non comprenderne il valore. Questo significa che la validazione, il giudizio critico e la responsabilità morale rimangono funzioni insostituibili ed esclusive dell'operatore umano.Infine, la terza differenza, forse la più profonda e quella con le implicazioni più sottili, è la totale mancanza di Esperienza Incarnata (Mancanza di Ancoraggio Fisico). La nostra comprensione del mondo e del linguaggio è indissolubilmente legata alla nostra esistenza fisica, al nostro "essere un corpo" nel mondo. Il significato di concetti come "caldo", "pesante", "vicino" o "rosso" non è puramente astratto; è ancorato a esperienze sensoriali (termocezione, propriocezione, vista) e fisiche dirette. Il nostro significato è referenziale: le parole si riferiscono a concetti, oggetti ed esperienze basati sulla nostra interazione con il mondo reale. "Rosso" è un'esperienza qualitativa legata ai fotorecettori nei nostri occhi. Un LLM, al contrario, è un sistema puramente testuale, un "cervello in una vasca" che ha letto l'intera biblioteca del mondo, ma non ha mai visto un albero, sentito il vento o toccato l'acqua. La sua "comprensione" è distribuzionale e statistica, non referenziale. Il modello "sa" che "caldo" è correlato a "fuoco", "sole" o "estate" non perché ha sperimentato la temperatura, ma perché queste parole appaiono frequentemente insieme (co-occorrenza) nei dati di training. Il suo è un vasto spazio semantico (inteso come la vasta rete di correlazioni apprese) multidimensionale, privo di qualsiasi ancoraggio al mondo fisico. Per un LLM, "rosso" è semplicemente un punto in questo spazio semantico vicino a "sangue", "mela", "stop" e "passione". L'implicazione pratica è che l'LLM non ha accesso al vasto, invisibile substrato di "senso comune" che noi esseri umani deriviamo dalla nostra esperienza fisica condivisa (es. l'acqua bagna, gli oggetti pesanti cadono verso il basso, spingere qualcosa la muove). Per noi, queste sono verità ovvie; per il LLM, sono solo altre correlazioni statistiche, non più "vere" di qualsiasi associazione fittizia trovata in un romanzo. Non possiamo dare per scontato che comprenda concetti basati sulla percezione, sull'azione o sull'interazione fisica. Qualsiasi riferimento a concetti spaziali, sensoriali o fisici deve essere disambiguato e definito testualmente, non potendo fare affidamento su un'esperienza condivisa che non esiste.

Queste tre mancanze ontologiche convergono in un'unica, fondamentale implicazione operativa: il collasso della comunicazione implicita. Gran parte dell'efficienza della comunicazione umana si basa su un enorme substrato condiviso. Ci capiamo rapidamente perché condividiamo la capacità di intuire le intenzioni (una capacità psicologica innata, nota come Teoria della Mente (ToM), di attribuire stati mentali come credenze, intenzioni, desideri, emozioni a sé stessi e agli altri), un background di esperienze culturali e storiche (un tessuto vivo di esperienze condivise, tradizioni, valori, convezioni sociali e riferimenti collettivi) e le leggi fondamentali della nostra esperienza fisica. Quando interagiamo con un LLM, questo substrato condiviso svanisce completamente. Siamo costretti a un esercizio di esplicitazione assoluta. Dobbiamo verbalizzare e trasferire nel prompt tutto ciò che, con un interlocutore umano, sarebbe dato per scontato.Consideriamo un esempio concreto per illustrare questo "collasso dell'implicito" e la necessità di una precisione chirurgica:Scenario di Interazione Implicita (Fallimentare):

Un utente ha appena terminato una riunione di lavoro complessa e vuole una riflessione sull'efficacia di una nuova metodologia di gestione progetto introdotta.

* Prompt Ambiguo (Utente): "Che ne pensi?"

* Processo LLM: Il modello riceve solo la sequenza di token "Che ne pensi?". Non ha accesso a un "modello mentale" dell'utente, né all'esperienza della riunione o alla conoscenza della metodologia discussa. Non possiede intenzione intrinseca di partecipare alla riflessione, né esperienza incarnata della "complessità" della riunione. La sua rete neurale attiva i pattern statistici associati a domande generiche, che nei suoi dati di training sono spesso seguite da richieste di chiarimento.

* Output LLM: "Per poterti fornire un'opinione significativa, avrei bisogno di più contesto. Potresti specificare a cosa ti riferisci? Un film, un libro, un concetto, o una situazione particolare?"

* Analisi: L'LLM, privo di Teoria della Mente, non può inferire che "quello" si riferisca alla riunione appena conclusa o alla metodologia discussa. La sua risposta è genericamente "plausibile" per una richiesta ambigua, ma completamente inutile per l'intento dell'utente, poiché non è riuscito a connettere il prompt a un contesto semantico specifico e non ha alcun meccanismo per "chiedere" con comprensione.Scenario di Interazione Esplicita (Efficace):

L'utente riformula la richiesta, incorporando esplicitamente l'intenzione e il contesto.

* Prompt Esplicito (Utente): "Agisci come un analista di processi esperti. Ho appena concluso la riunione del team sul progetto 'Aurora'. Siamo al terzo sprint e abbiamo implementato la metodologia 'Agile Scrum'. Valuta i potenziali pro e contro dell'applicazione di Scrum in questo contesto specifico, considerando che il team è composto da 8 persone e che i moduli software presentano elevate interdipendenze. Presenta l'analisi in un formato elenco puntato, con un paragrafo conclusivo sulle raccomandazioni."

* Processo LLM: L'LLM riceve una sequenza di token ricca di informazioni.

* Intenzione/Ruolo: "Agisci come un analista di processi esperti" definisce esplicitamente il ruolo e l'intento comunicativo che l'utente attribuisce al modello, bypassando la sua intrinseca assenza di volontà.

* Contesto: "progetto 'Aurora', terzo sprint, metodologia 'Agile Scrum', team di 8 persone, elevate interdipendenze tra moduli software" attiva le regioni pertinenti dello spazio semantico (inteso come la vasta rete di correlazioni apprese) relative alla gestione progetti, Agile, Scrum, dinamiche di team e sviluppo software. Non "capisce" il progetto, ma ha miliardi di esempi testuali correlati a questi termini.

* Obiettivo Comunicativo: "Valuta i potenziali pro e contro" orienta la generazione verso un'analisi bilanciata, non una semplice descrizione.

* Vincoli/Formato: "formato elenco puntato, con un paragrafo conclusivo sulle raccomandazioni" guida la struttura dell'output.

* Output LLM: L'LLM genererà un'analisi dettagliata e pertinente sui vantaggi e svantaggi di Scrum per un team di 8 persone su un progetto software complesso, attingendo ai pattern statistici di testi su Scrum, gestione progetti, dinamiche di team e sviluppo software, nel formato richiesto.

* Analisi: L'LLM ha simulato un'analisi complessa non perché "comprenda" il progetto nel senso umano o "intenda" aiutare, ma perché la sequenza di token fornita ha attivato le correlazioni statistiche più probabili per generare quel tipo di testo. L'utente ha assunto l'onere dell'esplicitazione, "parlando" al modello nel suo linguaggio statistico.Questo sforzo di esplicitazione, sebbene tecnicamente necessario per il prompt engineering, ha un potente e inaspettato effetto di ritorno. Ci costringe a disassemblare i nostri stessi processi di pensiero, a identificare i nostri presupposti impliciti, a chiarire le nostre intenzioni e a strutturare la nostra conoscenza in modo logico e privo di ambiguità. Questo si traduce in quattro pilastri operativi fondamentali per un prompt efficace:

1. L'Intento: Definire lo scopo, il ruolo (es. "Agisci come un critico letterario"), l'obiettivo e il pubblico dell'output.

2. Il Contesto: Fornire tutti i presupposti, i dati e le informazioni di background necessarie, senza dare nulla per scontato.

3. I Vincoli: Specificare i formati (es. "usa elenchi puntati"), i limiti di lunghezza, lo stile e le regole da seguire o evitare.

4. Il Significato: Disambiguare i termini chiave, specialmente quelli che dipendono da un'esperienza condivisa o dal senso comune.Interagire con l'AI, riconoscendone i limiti cognitivi, diventa così una potente palestra metalinguistica. Non stiamo solo imparando a "parlare alla macchina"; siamo costretti, nel processo, a ricalibrare le nostre stesse parole e, nel farlo, a raffinare in modo inestimabile la chiarezza e la precisione del nostro pensiero, valorizzando per contrasto le qualità uniche e insostituibili della cognizione e comunicazione umana.